400 606 5709

体验 DEMO

400 606 5709

体验 DEMO

400 606 5709

体验 DEMO

400 606 5709

体验 DEMO

2024年8月14日 • 作者:DataPipeline

一、项目背景与目标

在信创背景下,华东地区某重点城商行面临着关键的技术升级需求。银行急需一款能够替代OGG(Oracle GoldenGate)的数据同步工具,以支持新信贷系统数据库的国产化替代,并为未来对接更多国产数据库的需求做好充分准备。这一需求背后的关键因素包括:

· 实时采集能力的整合需求:该银行目前各类数据库都采用独立的采集插件,这种模式使得实时数据采集的能力碎片化,需要一个能够整合不同源端数据库增量数据的实时采集系统。

· 数据链路的复杂性:随着行内推出多款特色化小微金融服务工具,例如Pad金融移动服务平台及小微地图等,涉及的数据源和服务应用层日益增多,相应的数据链路也随之变得更加复杂。

· OGG的局限性:OGG在与国产数据库协同工作时面临较大限制,无法有效支持数据的实时同步,可能导致数据处理延迟或不一致,进而对业务决策、客户服务及合规性要求造成不利影响。

该银行的目标是部署一个高效、灵活且兼容国产数据库的数据采集与同步工具,以提升数据处理能力和业务响应速度,确保银行业务的连续性和客户服务的优质性。

二、为什么选择DataPipeline

经过全面的市场调研和比较同类产品后,该城商行认为DataPipeline在技术实力、用户体验和服务保障方面均表现优异,是最符合其业务需求的选择。

DataPipeline企业级实时数据融合平台不仅提供高效的数据处理能力,确保了银行数据开发中心的高响应速度,而且支持多种数据库系统,保证了应用的广泛适配性和稳定性。此外,简洁的用户界面和良好的市场口碑也使其在同类产品中脱颖而出。更为重要的是,DataPipeline提供7×24小时的客户服务和必要时的现场支持,这些都极大地增强了客户对产品的信赖与依赖,使其成为该银行首选方案。

三、实施方案

针对该银行的具体需求,DataPipeline提供了一套全面的解决方案,确保数据同步与处理的高效、稳定,并具备出色的灵活性和扩展性。

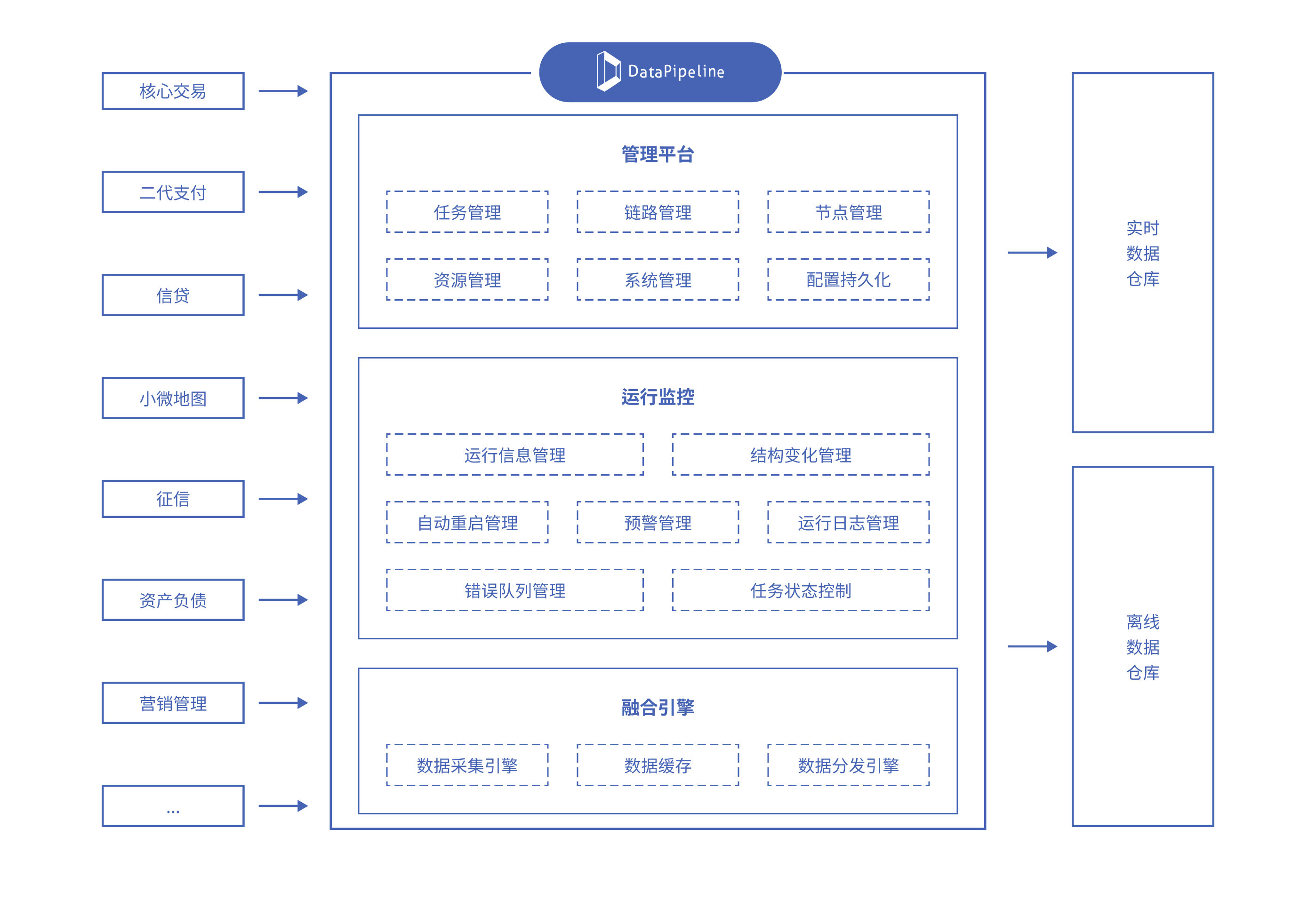

实时数据融合平台架构

▶ 实时数据融合与处理:DataPipeline企业级实时数据融合平台适配了包括Oracle、MySQL、OceanBase、TiDB、Vastbase等在内的多种数据库管理技术。这使得系统能够实现异构数据节点间的实时同步与批量数据处理,迅速响应全行业业务需求,并大大提高了抽数能力。这一策略直接应对了该银行因各类数据库使用独立采集插件而面临的实时采集能力碎片化问题。

▶ 无代码敏捷管理:DataPipeline提供了包括数据对象映射、灵活配置等十余种高级配置,通过无代码的敏捷管理功能,将数据融合任务的研发交付时间从按周计算降至分钟级,解决了该银行数据链路复杂性带来的问题。

▶ 可视化运维与全面的数据节点支持:通过DataPipeline的可视化界面,用户可以轻松配置表、实时监控数据变化与异常情况,确保能够有效掌控数据任务的各个状态,如激活、运行、暂停、报错、重启等。同时,支持的广泛数据节点,保证了系统的灵活性和扩展性,满足该银行对未来接入更多国产数据库的需求。

四、实施成果

项目自上线后已平稳运行半年左右,期间成功对接50多个系统,包括核心系统、电子银行、支付系统、理财平台、信贷系统以及人行征信系统等。此外,已打通约400个数据链路,且预计这一数字将继续增长。目前,DataPipeline每日同步约400张表,处理数百GB数据,单点日志解析量达到TB级别,平均解析延迟仅为秒级。

该城商行认为,DataPipeline实时数据融合平台不仅完全替代了OGG,而且在任务配置的易用性和功能设置方面表现出色。通过简单的系统配置,数据融合任务的研发交付时间大幅降低至分钟级。同时,DataPipeline的灵活性允许根据业务需求迅速配置数据链路和任务,极大提高了业务部门的数据使用效率。

项目的亮点包括:

1. 易用性和低开发成本:简单的前端配置不仅操作简便,还降低了开发成本。

2. 广泛的数据库覆盖与多样的同步场景:DataPipeline不仅支持从Oracle、 OceanBase、TiDB、Vastbase到DataHub的实时数据同步,也适用于批量数据同步,如从OceanBase(Oracle模式)或TiDB到MaxCompute等。DataPipeline还能处理大宽表,单次处理量达到3000万至1亿条记录,满足多样化的业务需求。

3. 数据同步连续性的保障:采用高可用部署架构和分布式部署的所有组件,即便有节点宕机,也能确保数据同步不中断。此外,平台还有数据同步异常监测功能,以及提供7×24小时的服务和必要时的现场支持,进一步确保数据同步的连续性和系统的业务连续性。

通过这些措施,DataPipeline不仅提高了数据处理的效率,也增强了系统的稳定性和可靠性,从产品到服务各方面都保障了数据同步的连续性,为该城商行提供了坚实的技术支持。

打造统一、稳定、可扩展的实时数据管理与计算能力底座,支撑核心业务、管理决策与风控场景的实时化升级

企业级实时数据底座的建立,使多源异构数据接入更加稳定高效,运维压力明显下降,架构弹性与扩展能力也得到全面提升。

项目不仅提高了运营效率,也让海信在用户服务和智能制造上具备了更强的前瞻能力。